최근 "OOO이 알려주는 승률 99%의 주식 투자"와 유명인을 사칭한 주식 투자 콘텐츠가 소셜 미디어에서 화제가 됐다. 아무리 신고하고 무시하려고 해도 계속 나타나고 있다. 바로 딥페이크 콘텐츠이다. 딥페이크는 유명인이나 정치인처럼 사칭하여 잘못된 정보 또는 잘못된 정보를 퍼뜨리거나 소비자를 사취하는 AI가 제작한 비디오 또는 오디오를 말한다.

인공 지능(AI)은 저작권, 전력 사용, 개인 정보 보호 문제 및 ChatGPT와 같은 챗봇의 잘못된 답변을 포함하여 다양한 이유로 논쟁의 여지가 있는 주제이다. 그러나 한 가지는 분명하다. AI는 문화에서 비즈니스에서 정치에 이르기까지 디지털 생활의 여러 계층에 점점 더 많이 스며들고 있다. 새로운 기술에서 흔히 볼 수 있듯이, 딥페이크 형태의 AI 불법 사용 증가는 AI의 인기 상승, 더 중요하게는 접근성 향상과 깊은 관련이 있다. 전 세계의 기업들은 이미 이러한 유형의 인공 콘텐츠의 영향을 느낄 수 있다고 스태티스타는 지적했다. 다음은 스태티스타가 공유한 딥페이크가 기업에 미치는 유형에 대해 공유했다.

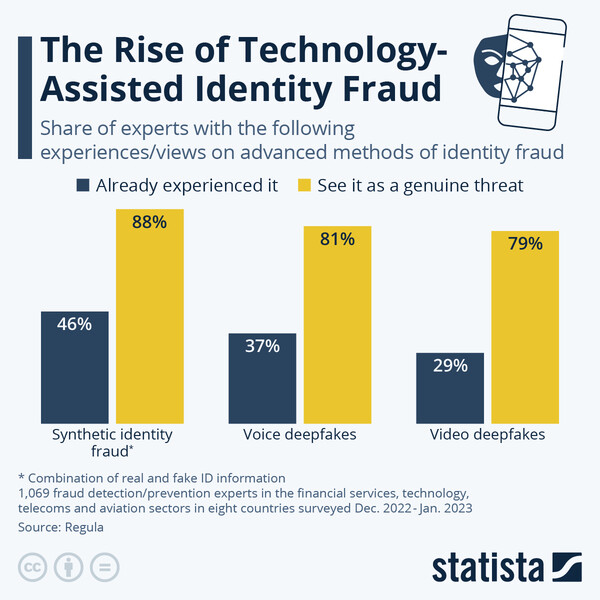

미국, 영국, 프랑스 및 독일과 같은 국가에서 온 사기 탐지 또는 예방 전문가 1,000명 이상을 대상으로 실시한 신원 확인 회사 레굴라의 설문 조사는 그들 회사의 상당 부분이 세 가지 방법 중 하나의 고급 신원 확인 사기의 표적이 되었다는 것을 보여준다. 응답자의 46%는 가짜 주민등록번호와 실제 이름, 주소 및 생년월일과 같은 실제와 가짜 신원 구성 요소의 조합이 사용되는 합성 신원 사기 사례를 경험했다.

37퍼센트는 음성 딥페이크가 사용되는 것을 보았다고 보고했다. 그 중 대표적인 사례는 지난 1월 바이든 대통령 목소리를 흉내내어 예비 유권자들에게 프라이머리에 참여하지 말라고 한 로보콜이다. 비디오 딥페이크는 현재로서는 덜 흔하며, 응답자의 29퍼센트만이 그러한 사기 시도를 이미 경험했다. 오픈AI의 소라와 같은 도구를 사용하여 이제 생성형 인공지능 회사들이 움직이는 사진에 초점을 맞추고 있기 때문에, 이 문제는 앞으로 몇 달과 몇 년 동안 더 분명해질 수 있다.

이러한 우려는 조사 대상 전문가들이 이 세 가지 사기 방법이 진정한 위협이 될 것이라고 생각하는 비율에도 반영되며, 80~90%가 이 평가에 동의한다. 레굴라의 최고 기술 책임자인 Ihar Kliashchou는 "AI로 생성된 가짜 신원은 특별한 훈련을 받지 않는 한 인간이 탐지하기 어려울 수 있다"고 말한다. "신경망은 딥페이크를 탐지하는 데 유용할 수 있지만, 물리적이고 동적인 매개 변수에 초점을 맞춘 다른 사기 방지 조치와 함께 사용되어야 한다."라고 덧붙였다.